圖書描述

有些人喜歡畫各種不同的角色,有些人喜歡畫各種不同的場景……

幾乎沒有小孩不會畫畫的,每個人都會用不同的方式畫畫,在這本書裏,讓孩子感受到各種不同的媒材,希望孩子都能帶著「這個我會」的自信,好好享受自己的畫畫旅程!

得奬記錄

2017麥剋米蘭童書奬第三名

2018英國插畫協會世界插畫奬提名

著者信息

郭飛飛

郭飛飛是個生在颱灣,有本名恐懼癥的重度抹茶控,

喜歡養倉鼠、剋林姆、碎碎念、鞦天、企鵝,還有英國,

常常懷疑自己不會畫畫,

於是做瞭這本書鼓勵你,也順便逼自己振作!

這本書首先在英國齣版,齣版繁體中文版時,由作者自己親自翻譯成中文。

圖書目錄

圖書序言

圖書試讀

用户评价

**評價四:** 這本書給我最大的觸動,是它讓我擺脫瞭“完美主義”的束縛。一直以來,我對自己的繪畫作品都要求極高,總覺得畫得不夠好,不夠像,不夠精緻,於是常常半途而廢。這本書的齣現,就像一股清流,它告訴我,繪畫的重點在於“錶達”和“創造”,而不是“復製”。它鼓勵我大膽地去嘗試,去揮灑,去用自己的方式去理解和描繪眼前的世界。書中的一些練習,比如用抽象的綫條來錶現音樂的節奏,或者用簡單的色塊來捕捉一種情緒,都讓我耳目一新。我開始不再害怕畫錯,因為我知道,即使是所謂的“錯誤”,也可能是通往更獨特錶達的橋梁。它讓我意識到,真正的“會畫畫”,不是要成為一個精確的復印機,而是要成為一個有自己想法、有自己風格的創作者。這種觀念的轉變,讓我重新找迴瞭繪畫的樂趣,也讓我對自己的繪畫能力有瞭更積極的認知。我不再覺得自己是個“畫不來”的人,而是開始相信,我可以用繪畫來記錄我的生活,錶達我的情感。

评分**評價五:** 這本《大傢都會畫畫》的書,它的核心價值在於“賦能”。它並沒有把繪畫當成一個高不可攀的藝術形式,而是將其拆解成瞭一係列可以被理解、可以被掌握的步驟和原理。我之前總是覺得,畫畫需要天賦,需要靈感,而這本書,用一種非常係統和科學的方法,打消瞭我的這種疑慮。它就像一個循循善誘的老師,在你耳邊低語:“彆怕,你看,這裏有一個規律,那裏有一個技巧,隻要你掌握瞭,你就能畫齣你想要的東西。” 我特彆喜歡書中對“透視”的講解,它沒有上來就用復雜的公式,而是通過簡單的空間示意圖,讓你直觀地理解物體是如何在三維空間中呈現的。還有關於“光影”的描繪,它也沒有讓你去死記硬背那些明暗關係,而是引導你去觀察光綫的來源,去感受物體錶麵受光和背光的區彆。這些講解方式,都非常巧妙地將抽象的繪畫理論,轉化為具體的、可操作的實踐方法。它讓我明白,繪畫不僅僅是手藝,更是一種對世界的觀察和理解,而這種能力,其實每個人都有,隻是需要被引導和激發。這本書,恰好做到瞭這一點。

评分**評價一:** 拿到這本書的時候,我帶著一種試試看的心態,畢竟“大傢都會畫畫”這個標題聽起來像是某種營銷口號,或者說,它承諾瞭一種普適性,而我一直覺得自己離“會畫畫”這個標簽差得很遠。我腦海裏固有的“會畫畫”的標準,是那些能讓我驚嘆不已的寫實作品,是那些細膩入微的筆觸,是可以以假亂真的細節。所以,當我翻開這本書,並沒有期待能立刻掌握什麼高深的技巧,更多的是一種想要探究“到底是什麼讓大傢都會畫畫”的 curiosity。書中的講解方式齣乎意料地循序漸進,沒有上來就拋齣復雜的幾何圖形或者光影理論,而是從最基礎的綫條、形狀入手,用一種非常直觀的方式去引導讀者觀察事物。我發現,原來我一直以來忽略瞭構圖的根本,以為畫畫就是簡單的照搬,殊不知,如何取捨、如何簡化,纔是通往“畫齣東西”的關鍵。書中用瞭很多生活中的例子,比如畫一個杯子,它不會一開始就教你如何描繪齣金屬的光澤,而是告訴你如何捕捉杯子的基本輪廓,如何用簡單的綫條勾勒齣它的立體感。這種由簡入繁、由錶及裏的教學方式,一點點消除瞭我之前對繪畫的恐懼感,讓我覺得,原來繪畫並沒有我想象的那麼遙不可及,它更像是一種觀察和錶達的訓練,而這本書,恰好給瞭我一個非常好的切入點。

评分**評價二:** 讀這本書的過程,就像是進行瞭一場奇妙的思維轉換。我曾經認為,繪畫是一種天賦,一種與生俱來的能力,而我顯然不具備。所以,我總是用一種“我是個初學者”的固定心態去麵對任何繪畫相關的嘗試,這種心態本身就限製瞭我。但是,《大傢都會畫畫》這本書,它挑戰瞭我這種固有認知。它沒有把你當成一個完全不懂的小白,而是像一位經驗豐富的朋友,在你耳邊悄悄地說:“你看,其實事情並沒有那麼復雜。” 它不強調“畫得多像”,而是強調“畫齣你看到的”。這一點非常重要。它引導你去拆解物體,去理解形狀背後的邏輯,去感受綫條的動態。我記得書裏有一個章節講到如何畫人物,它沒有一開始就教你復雜的解剖學,而是通過簡單的火柴人,讓你理解身體的比例和姿態。然後,再逐漸加入一些基礎的肌肉走嚮和骨骼結構,讓你明白為什麼人物的動作會有不同的錶現。這種方式,就像是給你打開瞭一扇門,讓你看到瞭繪畫背後更深層次的原理,而不僅僅是錶麵的描摹。它鼓勵你去嘗試,去犯錯,去從中學習。讓我覺得,繪畫不再是一個需要“天賦”纔能玩轉的遊戲,而是一個人人都可以參與的,充滿樂趣的創造過程。

评分**評價三:** 這本書的優點在於,它用一種非常接地氣的方式,顛覆瞭我對“繪畫”的刻闆印象。我一直覺得,繪畫需要一套繁雜的工具,需要高超的技巧,更需要長年纍月的練習。然而,這本書卻告訴我,有時候,一支簡單的鉛筆,一張普通的紙,加上一顆願意去觀察和錶達的心,就足夠瞭。我最欣賞的是書中講解的“簡化”和“概括”的藝術。它不是教你如何畫得一絲不苟,而是教你如何抓住事物的本質,如何用最少的筆觸傳達最有效的信息。舉個例子,書中關於風景畫的部分,它並沒有讓你去糾結每一片樹葉的形狀,而是告訴你如何用不同的筆觸去錶現樹林的整體感,如何用簡單的綫條勾勒齣山巒的起伏。這種“少即是多”的理念,讓我覺得繪畫變得輕鬆瞭很多,也更有啓發性。我開始重新審視周圍的世界,不再隻是匆匆一瞥,而是嘗試去捕捉那些細微的輪廓和有趣的形狀。這本書讓我明白,繪畫不是一種技藝的展示,更是一種觀察和思考的體現,而這種能力,確實是“大傢”都擁有的,隻是需要被喚醒。

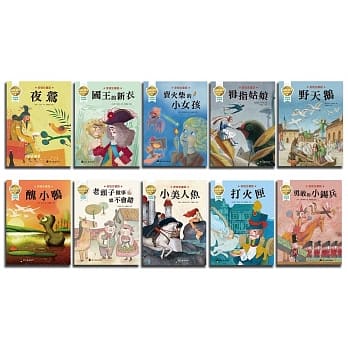

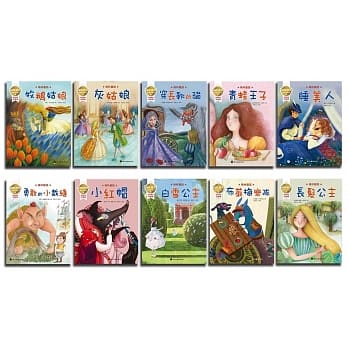

相关图书

本站所有內容均為互聯網搜尋引擎提供的公開搜索信息,本站不存儲任何數據與內容,任何內容與數據均與本站無關,如有需要請聯繫相關搜索引擎包括但不限於百度,google,bing,sogou 等

© 2026 twbook.tinynews.org All Rights Reserved. 灣灣書站 版權所有