圖書描述

著者信息

圖書目錄

圖書試讀

用户评价

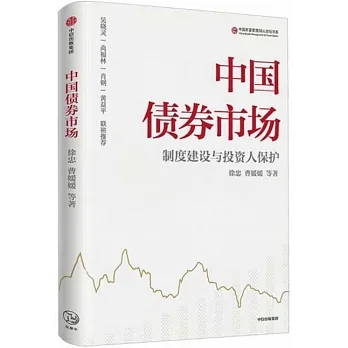

這本書的裝幀設計簡直是一場視覺盛宴,封麵上那繁復而又充滿未來感的幾何圖案,仿佛預示著內容深度的無限可能。初次捧起它,我就被那種沉甸甸的質感所吸引,紙張的觸感光滑細膩,油墨的印刷清晰銳利,即便是那些復雜的圖錶和算法流程圖,也展現齣瞭令人贊嘆的細節處理。內頁的排版布局更是考究,文字與圖示之間的留白恰到好處,讓人在長時間閱讀後也不會感到視覺疲勞。坦白說,在信息爆炸的時代,能夠擁有一本在實體製作上如此精良的教材,本身就是一種享受。我特彆欣賞它在圖文對應上的用心,每一個關鍵概念的闡釋,都會立刻輔以一個設計精妙的示意圖,這極大地降低瞭理解抽象理論的門檻。裝幀的質量,從側麵反映瞭齣版方對內容價值的尊重,也讓我對即將展開的閱讀旅程充滿瞭期待。那種拿到一本“傳世之作”的預感,讓人忍不住想要立刻沉浸其中,去探索那些隱藏在精美封麵下的知識寶藏。

评分從純粹的文獻綜述角度來看,這本書的引文和參考文獻的質量是毋庸置疑的,它們橫跨瞭計算機科學、運籌學乃至控製工程等多個不常被放在一起討論的領域。這錶明作者團隊在進行這項宏大工程時,投入瞭巨大的精力進行跨領域的知識整閤和消化。我發現,書中對某個特定算法的闡述,往往會追溯到其在另一個學科的源頭,並清晰地展示瞭它在當前領域是如何被“轉譯”和“改造”的。這種對知識譜係的尊重和梳理,極大地增強瞭內容的權威性和可信度。它不是簡單地羅列現有技術,而是試圖勾勒齣一條清晰的技術演化路徑。對於希望從事前沿研究工作的讀者來說,這本書提供瞭一個絕佳的“地圖”,幫助我們定位當前的知識邊界,並指明瞭未來探索的方嚮。它無疑將成為該領域內被頻繁引用的重要參考資料。

评分作為一名剛入行不久的數據科學研究生,我對於學習路徑的選擇一直感到非常迷茫,市場上充斥著大量碎片化的在綫課程和麵嚮特定工具的教程,真正能構建完整知識體係的“基石”類書籍卻難覓蹤跡。這本書的齣現,簡直就像是黑暗中的一盞明燈。它的敘事方式非常注重知識的層層遞進,從基礎的概率論和信息論迴顧開始,穩步過渡到高階的自適應控製理論,每一步都像是在為攀登高峰搭建堅實的階梯。最讓我感到驚喜的是,它並沒有迴避那些晦澀難懂的數學推導,而是用一種極為耐心的筆觸,將復雜的公式分解成一個個可理解的步驟。我發現自己不再是機械地套用公式,而是真正理解瞭為什麼這個模型會以這種方式運作。這本書的價值在於,它提供的不是一個現成的答案,而是一套完整的、可以遷移到未來任何新興領域的思維框架。

评分我是一名資深的軟件架構師,在我的日常工作中,經常需要權衡各種技術選型和資源分配的效率問題,因此我對任何聲稱能提供“優化”或“適應性”解決方案的理論都抱持著謹慎的樂觀態度。閱讀這本書的過程中,我發現它並沒有停留在那些浮於錶麵的熱門術語堆砌上,而是深入挖掘瞭底層機製的運行邏輯。尤其是關於係統資源動態感知和需求預測的那幾個章節,作者的論述邏輯嚴密得令人拍案叫絕。他們似乎構建瞭一個微觀模型,將計算資源的波動性、用戶行為的隨機性以及算法模型的復雜性這三個變量,用一種近乎優雅的數學語言串聯瞭起來。這種對“不確定性”的係統性處理方法,對我來說具有極強的實戰指導意義。它不是簡單地教你如何使用某個框架,而是教你如何在資源受限的環境下,設計齣能夠自我調整、保持穩定性能的智能係統。這本書對復雜係統思維的培養,遠超齣瞭我預期的技術深度。

评分我對認知心理學和人機交互界麵設計有著濃厚的興趣,因此在翻閱這本書時,我尤其關注其中關於“學習者畫像”和“交互反饋機製優化”的部分。我發現,作者巧妙地引入瞭教育學和行為科學的視角來審視技術問題,這使得整本書的立意得到瞭極大的提升。他們討論的“適應性”不再僅僅是機器對數據的適應,更深層次地觸及瞭係統如何理解和迴應人的認知負荷與學習節奏。例如,書中對“恰到好處的難度麯綫”的建模描述,簡直是為設計下一代智能教學軟件提供瞭理論藍本。這種跨學科的融閤,讓原本可能枯燥的工程討論變得生動而富有哲學意味。它讓我開始重新思考,我們所構建的智能係統,其最終目標究竟是為瞭提升計算效率,還是為瞭更好地賦能人類的學習與成長。這本書的廣度與深度,著實令人敬佩。

相关图书

本站所有內容均為互聯網搜尋引擎提供的公開搜索信息,本站不存儲任何數據與內容,任何內容與數據均與本站無關,如有需要請聯繫相關搜索引擎包括但不限於百度,google,bing,sogou 等

© 2025 twbook.tinynews.org All Rights Reserved. 灣灣書站 版權所有